Analyse des événements informatiques : une introduction complète

L’analyse des événements est un processus informatique qui traite de la résolution des défaillances et des incidents informatiques. Un événement peut désigner n’importe quelle modification de l’état ou de la condition d’un composant de votre réseau. Au cours de leur fonctionnement normal, tous les dispositifs technologiques créent des événements sous la forme d’entrées de log et de mise à jour d’état, enregistrées en tant que données d’événements dans différentes bases de données et autres fichiers. L’analyse des événements vise à améliorer la gestion et la compréhension de ces événements.

Traditionnellement, ces événements – et les actions qui s’ensuivent – devaient être gérés individuellement par des analystes, que ce soit à la suite de l’apparition de l’événement ou en parcourant manuellement des fichiers de logs pour rechercher des anomalies et des valeurs anormales. Les systèmes de gestion des événements ont fini par évoluer et donner aux responsables IT un moyen de parcourir rapidement les alertes et d’harmoniser leurs opérations. Malgré cela, avec la croissance constante des réseaux, le nombre et la complexité des alertes peut devenir ingérable dans les grandes entreprises. Pour cette raison, il est courant d’y trouver plusieurs outils pour gérer différents événements, allant de la réussite des GTM et des campagnes marketing à la latence réseau, dans différents segments de l’entreprise.

L’analyse des événements représente la nouvelle génération de la gestion d’événements, conçue pour consolider de multiples systèmes au sein d’une plateforme centralisée qui simplifie la découverte de la cause profonde des problèmes. Comme pour l’analyse cloud et l’analyse universelle, les algorithmes de machine learning ont également automatisé une grande part de ce processus, afin de réduire l’intervention humaine nécessaire pour résoudre les incidents et donner aux entreprises de tous les secteurs un avantage concurrentiel significatif dans cette ère numérique en constante évolution.

Splunk ITSI est un leader dans le domaine de l’AIOps

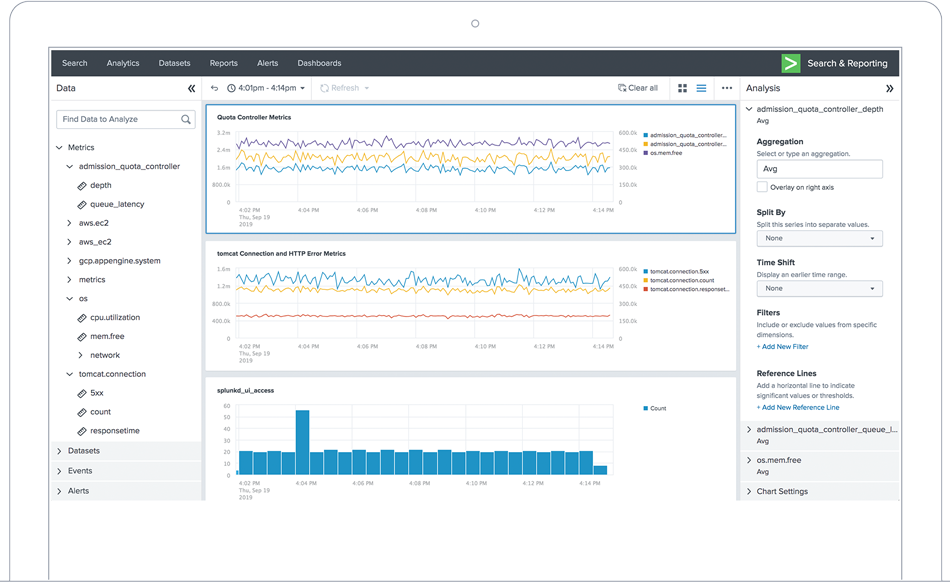

Splunk IT Service Intelligence (ITSI) est une solution d’AIOps, d’analytique et de gestion IT qui aide les équipes à anticiper les incidents avant qu’ils n’affectent les clients.

ITSI utilise l’IA et le machine learning pour corréler les données collectées auprès de nombreuses sources de supervision et offrir une vue unifiée des services IT et métiers pertinents. La solution a un double avantage : elle réduit les déluges d’alertes et permet la prévention des interruptions de service.

L’analyse des événements est un processus informatique qui traite de la résolution des défaillances et des incidents informatiques. Un événement peut désigner n’importe quelle modification de l’état ou de la condition d’un composant de votre réseau. Au cours de leur fonctionnement normal, tous les dispositifs technologiques créent des événements sous la forme d’entrées de log et de mise à jour d’état, enregistrées en tant que données d’événements dans différentes bases de données et autres fichiers. L’analyse des événements vise à améliorer la gestion et la compréhension de ces événements.

Traditionnellement, ces événements – et les actions qui s’ensuivent – devaient être gérés individuellement par des analystes, que ce soit à la suite de l’apparition de l’événement ou en parcourant manuellement des fichiers de logs pour rechercher des anomalies et des valeurs anormales. Les systèmes de gestion des événements ont fini par évoluer et donner aux responsables IT un moyen de parcourir rapidement les alertes et d’harmoniser leurs opérations. Malgré cela, avec la croissance constante des réseaux, le nombre et la complexité des alertes peut devenir ingérable dans les grandes entreprises. Pour cette raison, il est courant d’y trouver plusieurs outils pour gérer différents événements, allant de la réussite des GTM et des campagnes marketing à la latence réseau, dans différents segments de l’entreprise.

L’analyse des événements représente la nouvelle génération de la gestion d’événements, conçue pour consolider de multiples systèmes au sein d’une plateforme centralisée qui simplifie la découverte de la cause profonde des problèmes. Comme pour l’analyse cloud et l’analyse universelle, les algorithmes de machine learning ont également automatisé une grande part de ce processus, afin de réduire l’intervention humaine nécessaire pour résoudre les incidents et donner aux entreprises de tous les secteurs un avantage concurrentiel significatif dans cette ère numérique en constante évolution.

Qu’est-ce qu’un « événement » en analyse ?

Dans l’analyse, un événement est un enregistrement qui désigne une modification de l’état d’un dispositif sur le réseau. Les événements sont généralement produits avec une grande régularité. Par exemple, un serveur va enregistrer une action ou une entrée à chaque fois qu’une page web reçoit un certain nombre de vues ou de clics, ou toute autre interaction utilisateur. Dans un environnement très actif, les fichiers de log qui en résultent peuvent consommer plusieurs téraoctets de données par jour.

Un événement n’est pas forcément négatif. En effet, selon le type d’interaction, la grande majorité des événements sont bénins et attendus. Les événements se répartissent en trois catégories : information, avertissement ou exception, correspondant à différents niveaux d’inquiétude. Les outils de gestion et d’analyse des événements sont conçus pour aider les équipes à parcourir ces données pour déterminer où se situent les véritables problèmes ; ils facilitent la création d’une catégorie d’événements composée d’événements notables, d’épisodes, d’incidents et autres occurrences utiles. Enfin, ils génèrent des rapports réguliers et émettent des signalements en temps utile en cas d’anomalie.

Définir les données d’événements

Les « données d’événements » désignent les données supplémentaires ajoutées aux événements dans un index d’analyse. Les données d’événements incluent généralement l’encodage des caractères, l’horodatage, des métadonnées définies par l’utilisateur, des événements sans interaction et autres champs normalisés comme le nom de l’hôte ou la source de l’événement. Les événements peuvent également être segmentés au sein des données, et anonymisés au besoin.

Entre autres choses, les données d’événements accélèrent les recherches, facilitent l’analyse et offrent la possibilité de catégoriser les événements en fonction de critères personnalisés. De plus, lorsque l’index de données d’événements gagne en volume, les anomalies deviennent plus faciles à détecter grâce au suivi des événements, éclairant ainsi des tendances à long terme.

Qu’est-ce qu’un « incident » ?

Un incident est déclenché en cas de faille de sécurité ou d’interruption de service. Du point de vue de l’analyse, un incident commence par la découverte, dans l’index des événements, d’un motif potentiellement pertinent pour la sécurité ou le fonctionnement du système d’une entreprise. Lorsqu’un motif suspect est découvert, une entrée appelée événement notable est générée et identifiée à l’aide d’un code de suivi d’événement. Dans l’outil d’analyse des événements, le tableau de bord des incidents affiche tous les événements notables et épisodes. Les événements notables reçoivent une valeur numérique ou autre code qui lui affecte une valeur (ou une étiquette), afin de le catégoriser selon sa gravité et de faciliter la sélection, l’affectation, le suivi et la clôture des événements les plus graves.

Un workflow typique de gestion des incidents comprend un analyste administrateur qui supervise le tableau de bord d’examen des incidents, affecte une valeur numérique aux nouveaux événements notables tout en leur appliquant un tri de haut niveau relativement cursif au fil de leur création et de leur importation dans l’outil d’analyse des événements. Lorsqu’un événement notable nécessite une investigation, l’analyste administrateur affecte l’événement à un analyste examinateur qui entame une investigation formelle de l’incident. Une fois l’investigation terminée, l’analyste envoie l’événement à un dernier analyste qui vérifie et valide les modifications, puis ferme formellement le dossier.

Utiliser les recherches de corrélation pour identifier les événements et les incidents

Une recherche de corrélation est une recherche planifiée ou récurrente effectuée dans les logs d’événements pour détecter les événements et motifs suspects. Les utilisateurs peuvent configurer une recherche de corrélation pour qu’elle produise un événement notable lorsque certaines conditions sont remplies. Ces événements notables reçoivent un score de risque qui génère une action d’alerte correspondante à des fins de suivi d’événement. Les recherches de corrélation peuvent couvrir plusieurs types de données, ce qui permet aux responsables IT d’identifier plus précisément les motifs d’attaque suspects.

Une recherche de corrélation s’intéresse généralement à un besoin de sécurité particulier : clic d’utilisateur conduisant à un téléchargement malveillant, liens sortants infectés, JavaScript malveillant intégré dans une page web ou vulnérabilités dans un plug-in, entre autres. Si vous voulez être avertis lorsque des incidents de sécurité se produisent, une recherche de corrélation automatise ce processus via des recherches régulières dans l’index d’événements.

Identifier les événements notables

Un événement notable, ou événement important, est un enregistrement spécifique généré par une recherche de corrélation. Généralement, il prend la forme d’une alerte ou d’une création d’incident, délivrée à l’analyste quand certains critères sont remplis. Pour résumer, les événements notables sont ceux dont vous devez vous soucier.

Une politique d’agrégation des événements notables permet de grouper et d’organiser les événements notables. Ces politiques peuvent être créées par un analyste ou par un algorithme de machine learning qui va automatiser leur mise en œuvre. Au cours de ce processus, les doublons sont éliminés et un épisode est créé une fois que les événements ont été groupés de manière appropriée. La politique d’agrégation d’événements notables contient à la fois les événements et les règles qui automatisent les actions exécutées en réponse à un épisode. En d’autres termes, la politique contient à la fois le problème et la solution.

Grouper les événements notables en épisodes

Un épisode est un groupe d’événements notables qui ont été identifiés et rassemblés dans une même catégorie par un système d’analyse des événements. Les épisodes décrivent typiquement des événements potentiellement graves et ayant un effet néfaste sur les services : une interruption du réseau, une application qui ne s’exécute plus, du JavaScript malveillant ou un plug-in infecté, une faille de sécurité ou des interactions d’utilisateur entraînant une perte de données. Un épisode est généralement un sous-ensemble d’un incident, qui décrit une séquence plus longue et consistante d’événements.

Un système d’examen d’épisode indique la gravité des événements notables et attribue aux événements importants une valeur ou une étiquette qui sera utilisée par les analystes pour trier les différents épisodes affectant le réseau. Un épisode inclut une balise d’état qui précise s’il est nouveau, en cours (et à quel analyste il est affecté), résolu (quand le problème est résolu par l’analyste de traitement) ou clos (lorsqu’un dernier analyste a examiné le travail et confirmé que les modifications sont appropriées).

Utiliser les déclencheurs d’alertes

Les analystes peuvent configurer des conditions de déclenchement d’alertes qui peuvent être activées en temps réel ou selon un planning. Lorsqu’un analyste crée un ensemble de conditions de déclenchement d’alerte, les résultats de la recherche de corrélation (voir ci-dessus) sont comparés aux conditions. Ces conditions permettent à un analyste d’effectuer le suivi de plusieurs événements et champs de données d’événement. Par exemple, une condition de déclenchement peut être configurée pour superviser le taux de rebond d’une page web et déclencher une alerte lorsque ce taux dépasse le seuil prescrit.

On distingue deux types d’alertes : alertes en temps réel et alertes planifiées. Les alertes en temps réel recherchent les événements qualifiants et sont utiles lors de l’apparition d’une situation d’urgence exceptionnelle comme une interruption de serveur ou une coupure du réseau. Les alertes en temps réel peuvent être associées à une condition de déclenchement ponctuelle correspondant à un événement spécifique, afin d’informer l’analyste à chaque fois que la condition est remplie. Elles peuvent aussi être associées à une condition de déclenchement basée sur une période glissante, qui supervise les événements en temps réel mais ne génère une alerte que si les conditions sont remplies plusieurs fois sur une période donnée.

À l’inverse, les alertes planifiées ne sont pas exécutées en temps réel mais à intervalles réguliers. Elles sont généralement exécutées à des périodes moins chargées de la journée (tard dans la nuit, par exemple) ou à la fin d’une période définie. Les alertes planifiées récurrentes sont notamment utiles pour avertir si plus de dix transactions par carte de crédit inabouties ont été enregistrées au cours de la journée précédente, ou si des liens vers une page web malveillante ont été cliqués.

La place de l’analyse dans la gestion des événements

L’analyse des événements peut être considérée comme la prochaine révolution dans la technologie de gestion des événements. Les outils de gestion des événements sont utilisés pour superviser un composant ou un système particulier dans une infrastructure IT, alors que l’analyse des événements désigne souvent des systèmes qui possèdent des capacités très large et interfonctionnelles. Cela dit, il n’existe pas de véritable consensus sur l’usage de chaque terme, et ils sont souvent employés l’un pour l’autre.

Comme les systèmes d’analyse des événements, les outils de gestion des événements délivrent des services de détection, de notification et de filtrage. Ils permettent de répondre aux événements, de produire des rapports et de les clore après un tri. Bien que les outils de gestion des événements puissent avoir un champ d’action plus réduit, ils peuvent aussi être prédictifs et évolutifs. La gestion des événements est également un composant central des systèmes de SIEM, ou gestion des événements et des informations de sécurité, une technologie de gestion progressive de la sécurité qui permet aux analystes de sécurité de répondre aux menaces en temps réel.

La gestion des événements suit un processus très spécifique, de la création de l’événement à la résolution de l’incident.

Tout d’abord, les événements sont créés, généralement accompagnés de notifications de routine concernant des modifications normales des dispositifs dans l’entreprise. Toutefois, certains vont inévitablement dépasser les spécifications et les plages définies dans une recherche de corrélation par l’analyste d’événements. Ce sont les événements notables, et ils sont enregistrés en tant que tels dans le système de gestion des événements.

Au fur et à mesure que les événements notables sont filtrés et agrégés, ils sont regroupés en épisodes, qui circonscrivent un groupe d’événements notables dans une catégorie. La mission de l’analyste d’événements consiste à intervenir face à ces épisodes, tout d’abord en déterminant la valeur de l’événement et en appliquant un tri pour déterminer la meilleure réponse à donner à l’épisode : le résoudre directement ou l’affecter à un autre analyste. L’état de l’épisode passe sur « en cours » ou « en attente » pendant la durée d’investigation et d’intervention. Une fois une correction en place, l’épisode prend l’état « résolu ».

Un dernier analyste examine toutes les étapes précédentes et, si les résultats sont satisfaisants, il ferme l’épisode.

Prendre un bon départ avec l’analyse des événements

Les outils de supervision et d’analyse des événements d’aujourd’hui facilitent le démarrage. S’il est toujours possible d’installer une solution logicielle locale, les outils d’analyse basés dans le cloud, ou analyse cloud, représentent une option de plus en plus intéressante. Les outils d’analyse cloud sont plus simples à installer, nécessitent une infrastructure bien plus légère, et offrent des possibilités de configuration et de personnalisation tout aussi complètes que les outils locaux.

Voici les caractéristiques principales à rechercher :

- prise en charge d’une grande diversité de données machine et de dispositifs technologiques (serveurs, switches, bases de données, serveurs web, etc.),

- tableaux de bord dynamiques qui s’actualisent en temps réel, avec des visualisations très lisibles qui simplifient les données des épisodes pour les analystes,

- centralisation de la collecte d’événements provenant de sources aussi bien locales que cloud,

- possibilité d’effectuer un tri des épisodes et de leur attribuer des actions de remédiation en conséquence,

- possibilité de créer et gérer facilement les recherches de corrélation,

- une logique proactive qui prédit les problèmes avant qu’ils ne surviennent,

- stockage des données à long terme,

- des API et des SDK qui permettent des personnalisations plus fines et l’intégration à d’autres outils.

Une erreur à signaler ? Une suggestion à faire ? Contactez-nous à l’adresse ssg-blogs@splunk.com.

Cette publication ne représente pas nécessairement la position, les stratégies ou l’opinion de Splunk.

Articles connexes

À propos de Splunk

La plateforme Splunk élimine les obstacles qui séparent les données de l'action, pour donner aux équipes d'observabilité, d'IT et de sécurité les moyens de préserver la sécurité, la résilience et le pouvoir d'innovation de leur organisation.

Fondée en 2003, Splunk est une entreprise internationale. Ses plus de 7 500 employés, les Splunkers, ont déjà obtenu plus de 1 020 brevets à ce jour, et ses solutions sont disponibles dans 21 régions du monde. Ouverte et extensible, la plateforme de données Splunk prend en charge les données de tous les environnements pour donner à toutes les équipes d'une entreprise une visibilité complète et contextualisée sur l'ensemble des interactions et des processus métier. Splunk, une base solide pour vos données.