Stellen Sie die Service-Performance mit umfassender Transparenz, AIOps und Incident-Informationen sicher.

ÜBERSICHT

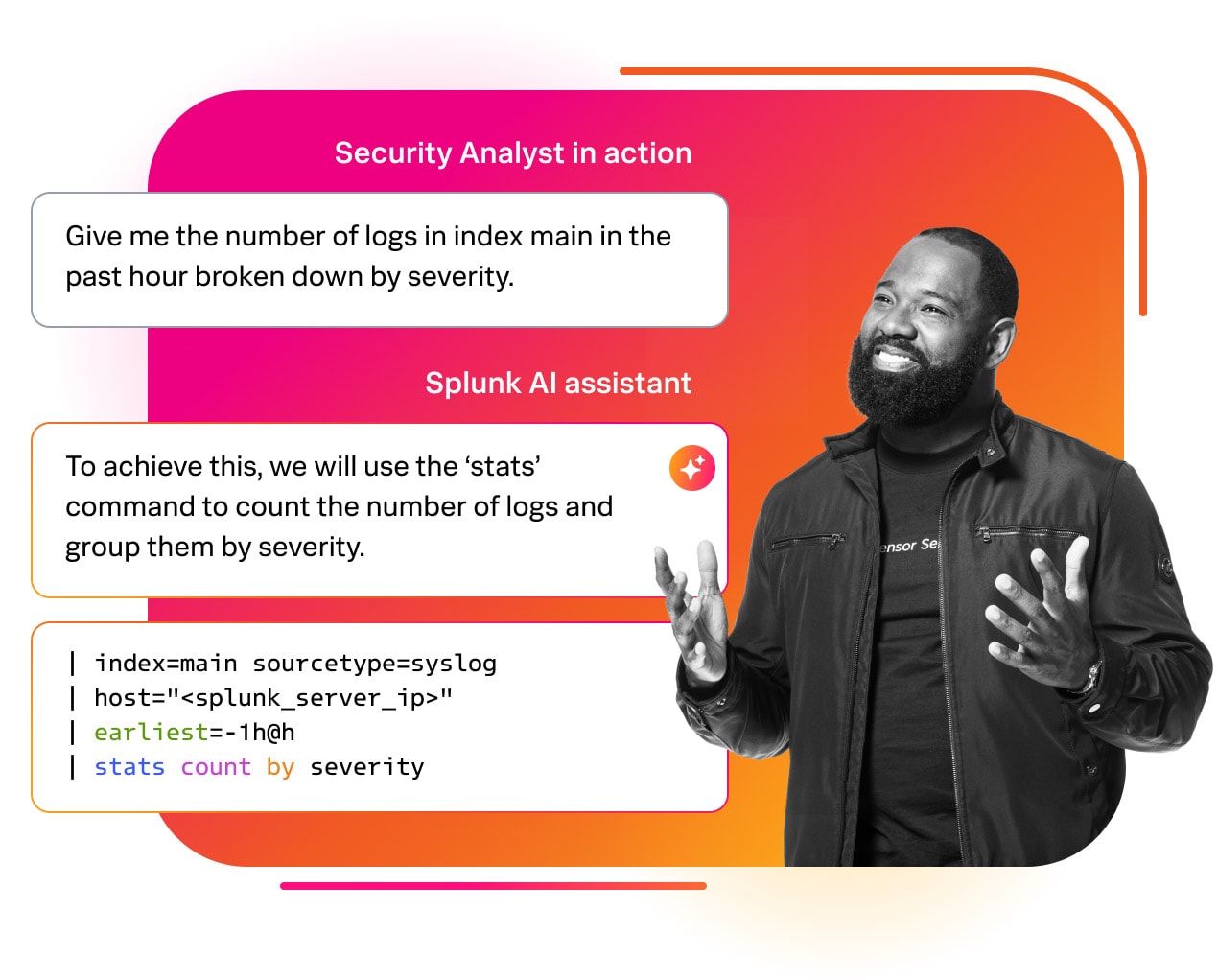

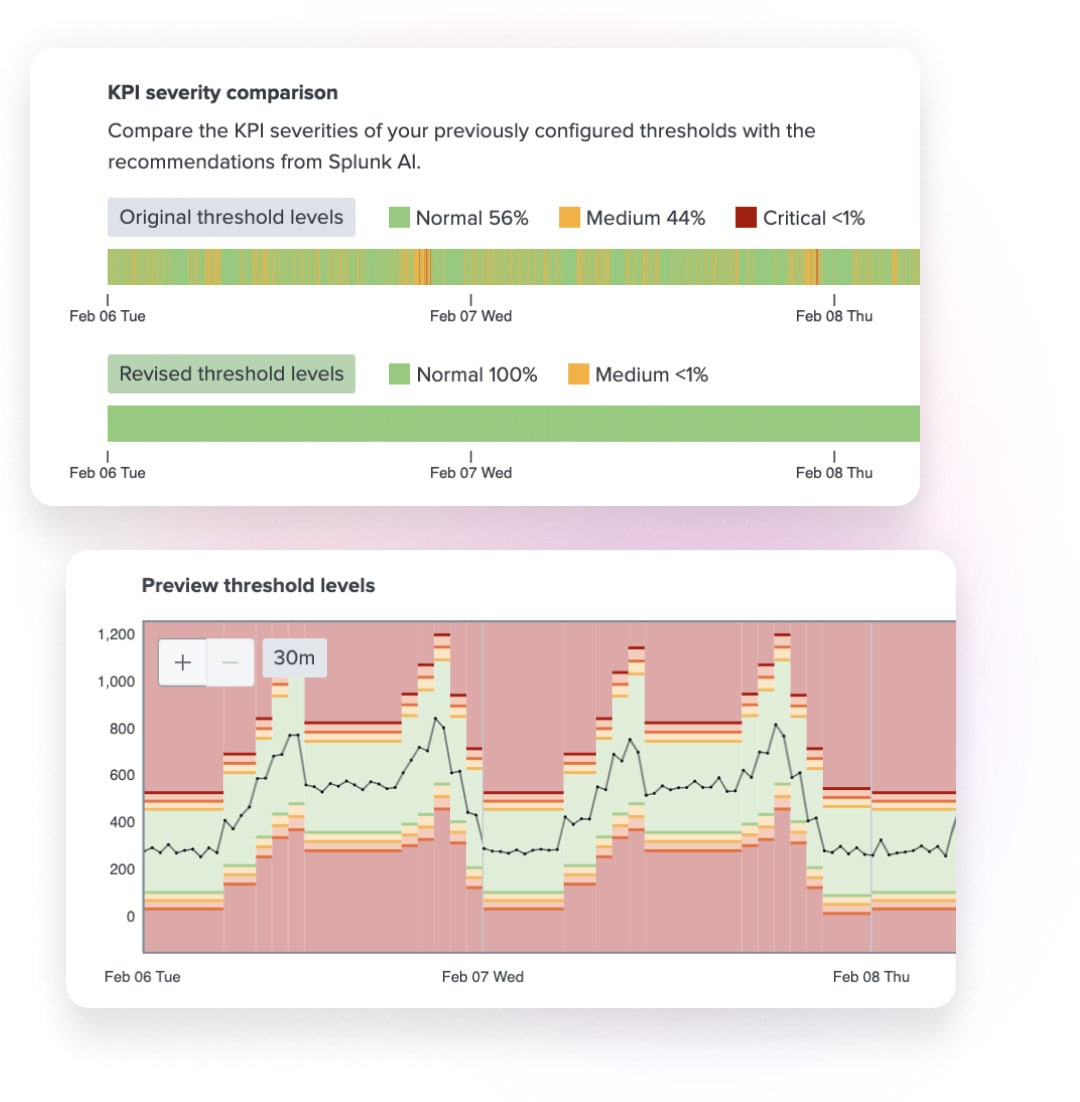

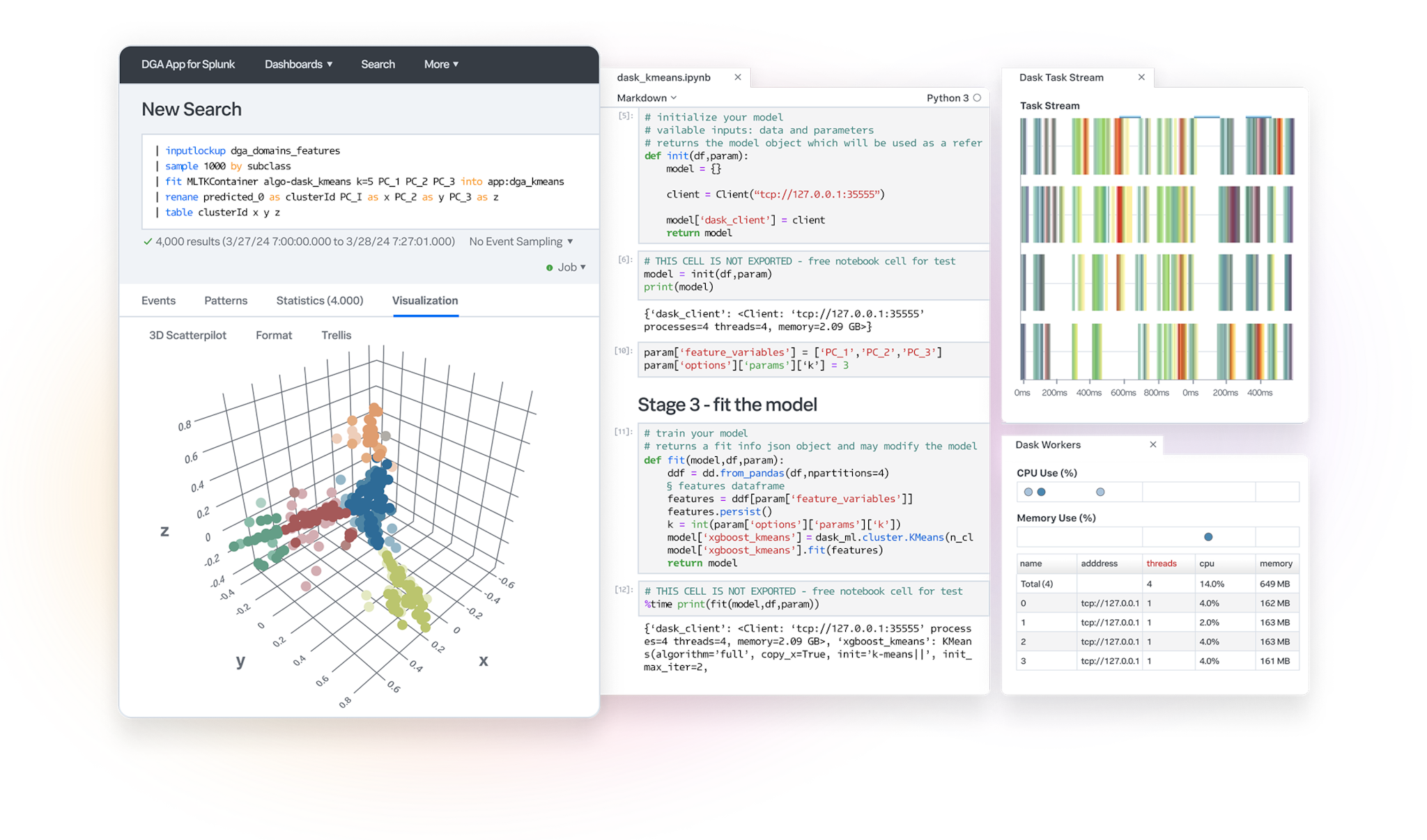

Setzen Sie mit Splunk AI neues Potenzial frei. Stellen Sie Ihren SecOps-, ITOps- und Engineering-Teams umfassenden Kontext und Interpretationen, schnelle Event-Erkennung und größere Produktivität durch menschengestützte Automatisierung zur Verfügung. Bewältigen Sie Ihre täglichen Use Cases mit leistungsstarker KI, die in die täglichen Workflows integriert ist.